Sprachmodelle zur Analyse radiologischer Befunde

In Krankenhäusern gewinnen Künstliche Intelligenz (KI) und große Sprachmodelle (LLMs) zunehmend an Bedeutung, insbesondere bei der Analyse und Strukturierung radiologischer Befunde.

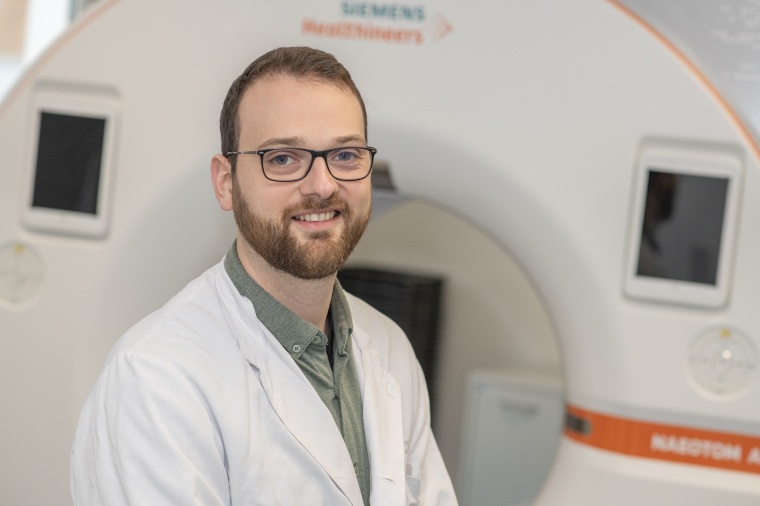

Forscher des Universitätsklinikums Bonn (UKB) und der Universität Bonn haben in einer Studie gezeigt, wie lokale LLMs datenschutzsicher eingesetzt werden können, um die Qualität der Informationsverarbeitung zu verbessern. Dr. Sebastian Nowak, Klinik für Diagnostische und Interventionelle Radiologie, Universitätsklinikum Bonn erläutert die Ergebnisse der Studie.

Dr. Jutta Jessen, Weinheim

M&K: Warum werden Künstliche Intelligenz und große Sprachmodelle (LLMs) in Krankenhäusern besonders im Bereich der Radiologie immer wichtiger? Gibt es spezifische Anwendungsfälle, bei denen LLMs besonders nützlich sein könnten?

Dr. Sebastian Nowak: Die jüngste Entwicklung von großen Sprachmodellen (LLMs) hat einen regelrechten Hype in der KI-Forschung ausgelöst, da sie das Potenzial zeigen, textbasierte Aufgaben in zahlreichen wissensbasierten Berufen automatisiert zu lösen. Die Medizin und insbesondere die Radiologie sind hiervon nicht ausgenommen. Ein charakteristisches Merkmal der Radiologie ist die enge Verbindung zwischen den textbasierten Befunden und den zugehörigen Bildern. Radiologen beschreiben in Freitextform die in den Bildern (z.B. CT oder MRT) sichtbaren Befunde und fassen dabei alle wichtigen Ergebnisse der durchgeführten Untersuchung zusammen.

Um das Erscheinungsbild von Erkrankungen in Bilddaten zu erforschen, ist es entscheidend, den Zusammenhang zwischen den Befunden und den entsprechenden Patientendaten herzustellen. Während es Bestrebungen gibt, Befunde zunehmend strukturiert zu erstellen, stellen bereits erhobene Daten, die überwiegend in Freitextform verfasst wurden, weiterhin eine große Herausforderung für retrospektive Studien dar. Bisher werden die für die Durchführung einer Studie erforderlichen Daten überwiegend manuell zusammengetragen, häufig beispielsweise im Rahmen einer medizinischen Promotion.

Hier kommen LLMs ins Spiel, indem sie wie ein wissenschaftlicher Assistent die Informationen in den Befunden lesen, verstehen und in eine strukturierte Form bringen, sodass die relevante Informationen strukturiert und maschinenlesbar in einer Datenbank nutzbar sind. Die strukturierten Daten können dann für die epidemiologische Forschung oder die Entwicklung weiterer KI-Diagnose-Tools genutzt werden. Es ist wichtig zu betonen, dass dies nur ein potenzieller Anwendungsfall von LLMs in der Radiologie ist, welchen wir in unserer Studie näher untersucht haben. Beispiele für weitere vielversprechende „Use Cases“ für LLMs in der Radiologie umfassen:

- Die Zusammenfassung der Patientenhistorie.

- Die Übersetzung von Befunden in andere Sprachen oder eine vereinfachte Form, um die Kommunikation mit Patienten zu unterstützen.

- Das Überprüfen von Widersprüchen zwischen geschriebenen Befunden und radiologischen Leitlinien.

- Das direkte Verfassen von Befunden basierend auf radiologischen Bildern als Vorschlag für den Radiologen, wie eine spannende, kürzlich veröffentlichte Studie von Google DeepMind in Nature Medicine zeigt (https://doi.org/10.1038/s41591-024-03302-1)

Diese breite Palette an möglichen Anwendungen unterstreicht das erhebliche Potenzial von LLMs, die Effizienz in der Radiologie zu steigern und die Qualität der Patientenversorgung zu verbessern. Es ist jedoch zu betonen, dass diese potenziellen Anwendungen stand heute hypothetisch sind und es umfassender Untersuchungen unter realen Bedingungen bedarf, um die tatsächliche Leistungsfähigkeit von LLMs in Bezug auf diese Aufgaben zu evaluieren.

Welche Vorteile bieten lokale LLMs im Vergleich zu kommerziellen Modellen, insbesondere in Bezug auf den Datenschutz?

Nowak: Manche Modelle werden unter einer offenen Lizenz veröffentlicht, welche es ermöglicht, das Model herunterzuladen und auf Grafikkarten-Servern, welche sich lokal im Kliniknetz befinden, auszuführen oder sogar weiterzuentwickeln. Prominente Beispiele sind offene LLMs, wie die Llama-Modelreihe von Meta, die Gemma-Modelreihe von Google, die Phi-Modelreihe von Microsoft oder Modelle des französischen Startups Mistral AI.

Im Gegensatz dazu ermöglichen kommerzielle, geschlossene Modelle, wie die GPT-Modelreihe von OpenAI, keine lokale Anwendung und erfordert eine Übertragung der Texte auf externe Server, oft sogar außerhalb der EU, was mit hohen datenschutzrechtlichen Hürden und Risiken verbunden ist, welche durch eine lokale Anwendung von LLMs innerhalb gesicherter Kliniknetzwerke nicht gegeben sind.

Bitte erläutern Sie die Studie, die Sie durchgeführt haben, um die Effektivität verschiedener LLMs zu testen?

Nowak: Unser Forschungsteam hat eine umfassende Studie durchgeführt, in der wir 17 offene und 4 geschlossene LLMs der genannten Hersteller auf ihre Fähigkeit hin untersucht haben, tausende Röntgenberichte in Freitextform zu analysieren und zu strukturieren. Wir haben sowohl geschlossene als auch offene LLMs mit öffentlichen, und daher ohne Datenschutzbedenken nutzbaren, englischsprachigen Befunden ausgewertet. Zusätzlich haben wir die offenen, lokalen LLMs auf datenschutzsensitive, deutschsprachige Befunde aus dem Universitätsklinikum Bonn ausgewertet und zusätzlich untersucht, wie die LLMs auf diesen weiterentwickelt werden können.

Welche Ergebnisse haben Sie bei der Analyse der verschiedenen LLMs erzielt?

Nowak: Die Auswertung der LLMs auf öffentlichen, englischen Befunde zeigt, dass die geschlossenen GPT Modelle von OpenAI keine signifikanten Vorteile gegenüber den leistungsfähigsten offenen LLMs aufwiesen. Bei der direkten Anwendung der LLMs ohne vorheriges Training schnitten große, offene LLMs besser ab als kleinere offene Modelle, sowohl auf den englischen, als auf den deutschen Befunden.

Welche Rolle spielt dabei das Training der LLMs bei der Verbesserung ihrer Leistung?

Nowak: Die Weiterentwicklung auf Basis der von uns händisch strukturierten, deutschen Befunden führte zu einer effektiven Verbesserung der LLMs, sogar mit relativ wenigen manuell bearbeiteten Befundberichten. Dies verringerte auch den Leistungsunterschied zwischen großen und kleinen LLMs, welche mit weniger Rechenleistung und damit günstigerer Hardware ausgeführt werden können.

Wie haben Sie die Qualität der verschiedenen LLMs bewertet?

Nowak: Die Qualität der LLMs wurde anhand ihrer Fähigkeit bewertet, spezifische, klinisch relevante Informationen aus radiologischen Befunden von Röntgenaufnahmen der Lunge korrekt zu erkennen und zu extrahieren. Insbesondere haben wir die Leistung der Modelle untersucht hinsichtlich des Vorhandenseins von Lungeninfiltraten, Pleuraergüssen, Lungenkongestion, Pneumothorax sowie der Positionierung des Zentralen Venenkatheters (regelrecht oder fehlplatziert).

Um die Genauigkeit dieser Erkennungen zu quantifizieren, haben wir den F1-Score als statistische Metrik verwendet. Dieser Score bietet eine ausgewogene Bewertung von Präzision und Recall, um die Gesamtleistung der Modelle zu erfassen. Zur Beurteilung von Unterschieden in der Leistung zwischen den verschiedenen LLMs haben wir 95%-Konfidenzintervalle analysiert.

Welche Herausforderungen haben Sie bei der Implementierung von LLMs in der Klinik festgestellt?

Nowak: Die Implementierung von LLMs, insbesondere der großen Modelle mit zahlreichen Parametern, stellt mehrere Herausforderungen dar. Zum einen erfordert die Ausführung und Weiterentwicklung dieser Modelle leistungsstarke Grafikkartenserver. Selbst mit der Anwendung von Techniken, um die Modellanforderungen zu reduzieren, wie die Quantisierung, der Modelparameter, lag der Euro-Wert für den erforderlichen Server für das größte lokale Modell in unserer Studie im niedrigen sechsstelligen Bereich. Im Gegensatz dazu können kleinere Modelle auf Grafikkarten-Rechnern mit einem Wert von nur wenigen Tausend Euro ausgeführt werden. Neben den hohen Hardware-Kosten erfordert die Betreibung von Grafikkartenservern IT-Fachkenntnisse und Serverräume mit geeigneter Kühlung.

Für eine lokale Weiterentwicklung von offenen LLMs ist neben medizinischem Fachwissen zusätzlich die Expertise von Data Scientists erforderlich. Dies umfasst die Aufbereitung von Trainingsdaten, die Erstellung und Ausführung von Trainingsskripten auf dem Server sowie die Überwachung und Optimierung des Trainingsprozesses. Diese zusätzliche Hardware und Personalkompetenz kann für kleinere Kliniken oder solche mit begrenzten Ressourcen eine weitere Hürde darstellen.

Gibt es Pläne, Ihre Forschungsergebnisse und Methoden mit anderen Kliniken zu teilen?

Nowak: Ja, wir möchten andere Kliniken in die Lage versetzen, direkt von unseren Forschungsergebnissen zu profitieren. Aus diesem Grund haben wir den Programmcode und die Methoden für die Nutzung und das Training von LLMs unter einer offenen Lizenz auf GitHub (siehe QR-Code) veröffentlicht.

Zur Person:

Anschließend an sein Studium der Angewandten Physik an der Universität und Hochschule Koblenz promovierte Dr. Sebastian Nowak an der Universität Bonn im Fach Experimentelle Medizin. Er erforschte als Datascientist und Wissenschaftlicher Mitarbeiter in der Abteilung für Diagnostische und Interventionelle Radiologie des Universitätsklinikums Bonn die Möglichkeiten und Grenzen der Anwendung von bildbasierter Künstlicher Intelligenz und textbasierten LLMs in der Radiologie.